En général, quand nous recevons des messages qui nous bousculent, mais qui proviennent de sources crédibles, nous nous efforçons d’intégrer ces arguments dans notre vision du monde. […] La plupart des gens réagissent de façon rationnelle face aux arguments présentés. Ils rejettent d’emblée ceux qui leur paraissent fallacieux, se laissent plus facilement convaincre par les arguments solides et changent d’avis en conséquence.

MERCIER Hugo, Pas né de la dernière pluie, humenSciences, Paris, 446 pages.

J’ai raccroché deux passages du livre d’Hugo Mercier dans lequel il défend la thèse que les gens ne sont pas si crédules qu’on le pense*. La citation présentée telle quelle pourrait faire se dire à de nombreuses personnes « n’importe quoi, les gens sont bêtes pour la plupart ». Ou encore, « les gens n’ont pas envie de changer d’avis, peu importe les preuves présentées ». Penser que les gens ne sont pas crédules et qu’ils ont l’honnêteté intellectuelle de changer d’avis face à des preuves peut donc paraître contre-intuitif. Je suis moi-même peu enclin à croire ces propos comme ça à chaud, mais ne pas explorer les preuves allant dans ce sens serait justement assez malhonnête. Voyons voir ce qu’il en est, et s’il me faut changer d’avis sur cette question : les gens sont-ils vraiment comme je pense qu’ils sont ?

La vérité compte-t-elle pour les électeurs ?

Une des références utilisées par Hugo Mercier dans le passage cité plus haut est une étude australienne1 sur un échantillon de plusieurs centaines d’électeurs. Cette étude montre que les gens, même politiquement orientés, ne sont pas intrinsèquement réfractaires au fait de changer d’avis et d’ajuster leurs croyances, en privilégiant les faits aux mythes. Il est important de noter que le format de l’expérimentation ne laissait pas la possibilité aux personnes d’éviter les informations qu’on leur apportait pour réévaluer leurs positions. En effet, dans le vrai monde, il nous est assez facile de nous enfermer dans des bulles de filtre et de ne recevoir qu’un certain type d’information fortement teinté d’idéologie en fonction de la source qu’on choisit. Ainsi, on pourrait alors se dire qu’il pourrait être intéressant de « forcer » (c’est un mot fort, mais discutons-en) les gens à prendre en compte des informations.

Pour autant, le fait d’être forcés en un sens d’aborder certaines informations pouvant déclencher un questionnement amenant à un changement de position n’a pas été mal reçu par les personnes de l’échantillon, ce qui laisse tout de même envisager le fait que les gens peuvent entendre des opinions contraires, et modifier leurs croyances en fonction de la véracité des informations. Cependant, il a été noté que les personnes ayant une position solidement ancrée dans une opinion était tout de même difficile à changer même avec des bons arguments, quand bien même la position en question ne serait pas elle-même solide au niveau des preuves pour la soutenir.

En fin de compte, les résultats de l’étude suggèrent que la vérification des faits pourrait servir de véritable menace à l’éligibilité des politiciens qui font régulièrement de fausses déclarations. Cette menace pourrait, à son tour, diminuer la fréquence à laquelle les politiciens diffusent des informations erronées. À l’appui, Nyhan et Reifler2 ont trouvé des preuves suggérant que les représentants des États américains faisaient moins de déclarations inexactes si on leur rappelait la présence de « fact-checkeurs » dans leur État et les conséquences potentielles, en termes d’élection ou de réputation, d’une évaluation négative de la vérification des faits. Cela dit, le « potentiel de menace » de la vérification des faits peut être plus important dans les pays où le vote est obligatoire (comme en Australie) que dans les pays où le vote est volontaire, où l’insatisfaction liée à une vérification négative des faits peut inciter les gens à s’abstenir de voter.

En outre, il convient de noter que cette étude ne permet pas d’établir le caractère durable des changements éventuels dans les croyances, les intentions de vote ou la véracité perçue, car ces variables ont été mesurées immédiatement après la présentation des fact-checks. En réalité, il y aura souvent un délai plus long entre le moment où les gens sont confrontés à la vérification des faits et celui où ils prennent des décisions concernant les politiques ou les politiciens, et l’impact de la vérification des faits sur les croyances est susceptible de s’estomper au moins partiellement au cours de cette période3. Si les croyances reviennent partiellement à leur position initiale au fil du temps, il se peut que les attitudes fassent de même. Cependant, il est également plausible que les gens puissent oublier les détails des vérifications des faits – c’est-à-dire ce que les vérifications des faits ont dit sur les sujets abordés – tout en se souvenant qu’ils ont indiqué que le politicien était incorrect. Dans ce cas, l’impact des vérifications des faits sur les attitudes pourrait rester assez stable. Il serait intéressant que les études futures apportent plus de clarté sur la façon dont l’impact des vérifications des faits évolue dans le temps en mesurant les croyances et les attitudes après un délai. Enfin, on ne sait pas non plus dans quelle mesure une réduction des sentiments et du soutien est nécessaire pour modifier réellement un vote ; l’éclairage de cette relation pourrait également constituer un objectif pour les recherches futures.

Concernant les changements d’avis sur des opinions politisées, on peut s’appuyer sur une vidéo de Mehdi Moussaid qui illustre bien les changements de position et quel groupe est souvent visé pour faire pencher la balance d’un côté plutôt que l’autre dans un contexte où l’on cherche à prendre une décision collective.

Debunking : la démystification est-elle possible ?

Une méta-analyse4 citée par Hugo Mercier nous permet d’aborder la question du debunking. On commence à avoir l’habitude avec ce terme, grâce entre autres à des personne comme Defakator, l’équipe de la Tronche en Biais et tout un tas de zététiciens ou même des personnes politiques qui ont tout à gagner à remettre un peu d’ordre dans cette ère de la « post-vérité« .

Ses résultats concernant la génération d’explications conformes à la désinformation étaient cohérents avec l’hypothèse selon laquelle les personnes qui génèrent des arguments soutenant la désinformation ont du mal à remettre en question et à changer leurs attitudes et croyances initiales.

Le message de démystification était moins efficace lorsque les personnes étaient initialement plus susceptibles de fournir des explications à l’appui de la fausse information que lorsqu’elles ne l’étaient pas. Les résultats de la contre-argumentation de la désinformation ont également confirmé les prédictions. Le message de démystification était plus efficace lorsque les personnes étaient plus susceptibles de contre-argumenter la désinformation que lorsqu’elles ne l’étaient pas. En outre, les résultats concernant le détail des messages de démystification étaient conformes à l’hypothèse des chercheurs selon laquelle la démystification est plus efficace lorsqu’elle fournit des informations qui permettent aux destinataires de mettre à jour le modèle mental justifiant l’information erronée.

L’effet de démystification était plus faible lorsque le message de démystification qualifiait simplement la désinformation d’incorrecte que lorsqu’il introduisait des informations correctives. Cependant, contrairement aux attentes, les effets de démystification des messages de démystification plus détaillés ne se sont pas traduits par une réduction de la persistance des fausses informations, car les études avec démystification détaillée pourraient également présenter une persistance plus forte des fausses informations.

Les personnes convaincues restent convaincues, peu importe si c’est « pour » ou « contre », d’où l’importance de surtout cibler les indécis.

A la lumière de ces résultats, les chercheurs proposent donc trois recommandations : (1) réduire les arguments qui soutiennent la désinformation, (2) engager les publics à examiner et à contre-argumenter la désinformation, et (3) introduire de nouvelles informations dans le cadre du message de démystification. Bien entendu, ces recommandations ne tiennent pas compte des caractéristiques de disposition du public et peuvent ne pas être efficaces ou moins efficaces pour les personnes ayant certaines idéologies5 et certains contextes culturels6.

Recommandation 1 : réduire la production d’arguments en fonction de la désinformation.

Les résultats suggèrent que l’élaboration d’arguments allant dans le sens de la désinformation réduit l’acceptation du message de démystification, ce qui rend difficile l’élimination des fausses croyances. L’élaboration des raisons d’un événement particulier permet aux destinataires de former un modèle mental qui peut par la suite biaiser le traitement des nouvelles informations et rendre difficile l’élimination de la croyance initiale7. Par conséquent, les médias et les décideurs politiques doivent rendre compte d’un incident de désinformation (par exemple, un rapport de rétractation) de manière à réduire les réflexions détaillées en en faveur de la désinformation.

Recommandation 2 : créer des conditions qui facilitent l’examen et la contre-attaque des fausses informations.

Nos résultats mettent en évidence la conclusion selon laquelle le fait de contredire la désinformation renforce le pouvoir des efforts de correction. Par conséquent, les mécanismes publics et les initiatives éducatives devraient induire un état de scepticisme sain. En outre, lorsque des rétractations ou des corrections sont publiées, faciliter la compréhension et la génération de contre-arguments détaillés devrait permettre une acceptation optimale du message de démystification.

Recommandation 3 : corriger la désinformation par de nouvelles informations détaillées, mais maintenir les attentes à un niveau bas.

Les analyses modératrices indiquent que les destinataires de la désinformation sont moins susceptibles d’accepter les messages de démystification lorsque les contre-messages se contentent de qualifier la désinformation d’erronée plutôt que de la démystifier avec de nouveaux détails8. Une mise en garde s’impose : la persistance ultime de la désinformation dépend de la façon dont elle est perçue au départ, et la démystification détaillée ne fonctionne pas toujours comme un moyen efficace d’éliminer les fausses informations.

L’efficacité de la démystification.

Une étude britannique de 2019 s’est intéressée à l’efficacité de « fact-checkings » au format court9. Elle visait à creuser deux questions :

- Les vérifications des faits d’un format particulièrement courant – celles qui répètent une fausse affirmation et la marquent simplement comme fausse – sont-elles inefficaces et potentiellement nuisibles ?

- Les réfutations qui mettent en œuvre un certain nombre de recommandations de meilleures pratiques, mais dans des limites d’espace très strictes, sont-elles plus efficaces que les rétractations qui se contentent d’étiqueter les fausses allégations pour réduire la croyance dans les fausses allégations et le raisonnement conforme aux fausses allégations ?

Les résultats ont été clairs et ont montré que les rétractations simples – des messages qui répètent une fausse affirmation tout en la marquant comme fausse – n’ont pas eu d’effet négatif par rapport à l’une ou l’autre ligne de base. En fait, les rétractations ont considérablement réduit la croyance en de fausses affirmations par rapport au niveau de pré-correction dans le même échantillon, ainsi que par rapport au niveau de croyance exprimé par un autre échantillon après une exposition initiale, non contestée, aux fausses affirmations.

Cependant, la désinformation peut avoir un effet plus fort si la source est une personne que l’on juge fiable, ce qui implique aussi que si un « fact-checkeur » est perçu comme fiable, il aura lui aussi une plus grande efficacité dans sa demystification10. Cela marque l’importance des relations sociales et aussi des divers biais cognitifs comme l’effet de halo ou encore l’effet blouse blanche dans la croyance en certaines informations (si l’on part du principe que les gens se contentent de recevoir une information sans la vérifier).

Des études se sont intéressées à l’effet « retour de flamme », c’est-à-dire la réactance que des personnes peuvent avoir face à des informations qui les contredisent et qui pointent d’autres informations comme fausses et trompeuses. Un papier scientifique nous rapporte donc grâce à trois études menées11 que quand les gens sont exposés à de l’information, ils mettent à jours leurs visions dans le « bon sens », c’est-à-dire en direction des opinions les mieux supportées par des faits. Cependant il faut toujours garder à l’esprit qu’en dehors d’un cadre expérimental, il est possible que les personnes évitent de manière consciente ou non des médias qui pourraient leur donner tort.

De plus, les gens consomment surtout du média de divertissement plutôt que du média d’information, ce qui laisse aussi envisager que beaucoup de personnes sont tout simplement peu intéressées par les « pro-x » ou les « contre-y ». Il n’y aurait alors pas d’effet « retour de flamme » particulier à part dans certaines situations spécifiques. Une étude de 2019 avec un échantillon de plusieurs milliers de personnes12 appuie cette idée qu’il n’y aurait pas de réactance particulière à un consensus scientifique comme celui concernant le changement climatique.

Il est intéressant de rajouter à cela les résultats d’une méta-analyse de 2018 montrant que les tentatives de correction peuvent réduire la désinformation dans divers domaines, publics et conceptions13. Plus particulièrement, les corrections ont un effet de niveau modéré sur les croyances liées à la désinformation, qui persiste même après avoir contrôlé l’erreur de mesure. L’analyse a également révélé que les tentatives de correction semblent mieux réussir à informer le public sur la santé que sur la politique. Il semble que les gens soient plus résistants au changement lorsqu’il s’agit de leur identité politique.

Une explication potentielle de la résistance associée à la désinformation politique a trait à l’éducation. Alors qu’un niveau d’éducation plus élevé est généralement un prédicteur positif de l’acceptation de l’autorité sanitaire et scientifique, lorsqu’il s’agit de politique, les tentatives de correction semblent être moins efficaces, en particulier chez les partisans politiques plus éduqués14. Comme prévu, les résultats indiquent que la désinformation construite est plus facile à démystifier par rapport à la désinformation du monde réel. Que ce soit en raison d’une faible implication ou d’un manque d’exposition préalable, les gens semblent être plus ouverts d’esprit lorsqu’ils envisagent de corriger une désinformation construite.

On peut également affirmer que les individus sont motivés pour rejeter la correction des fausses informations du monde réel, car elles peuvent constituer une menace pour des aspects importants de leur identité sociale. Si l’on considère la validité écologique limitée de la désinformation construite, la puissance des messages correctifs dans les contextes du monde réel semble faible. La polarisation politique quant à elle influence aussi beaucoup les réactions des gens quant aux informations qui leur sont présentées.

L’exemple de l’immigration.

En France, j’ai la sensation que le sujet de l’immigration est toujours assez sensible, bien que l’on se soit tout de même éloigné des positions très caricaturales telles que « ils nous volent notre travail ! ». Désormais ils veulent surtout nous « grand remplacer » !

La gauche elle-même est divisée sur la manière d’aborder la question, tandis que pour la droite l’immigré est un coupable idéal pour les maux économiques et sociaux du pays. Le centrisme éclairé de Macron quant à lui tente de jouer sur les deux tableaux en accueillant des futurs travailleurs pas chers. Mais trêve d’opinions politiques biaisées, est-il possible de faire changer d’avis les gens sur la question de l’immigration ?

Quoi de mieux qu’une étude au Japon pour parler de ce sujet ? Je pense qu’il n’est pas un secret qu’au Japon le racisme et la xénophobie en général sont très ancrés dans les moeurs15. Giovanni Facchini et ses collègues ont donc eu une idée plutôt intéressante que d’aller étudier la possibilité d’un changement d’avis sur les questions d’immigration au Japon16. Si des japonais peuvent changer d’avis, on peut faire l’hypothèse que c’est possible plus globalement pour le genre humain.

Dix milles personnes ont constitué l’échantillon pour l’expérimentation. En assignant aléatoirement aux participants différents textes, dont certains soulignaient l’impact potentiel de l’immigration pour atténuer des problèmes tels qu’une population âgée croissante nécessitant des soins ou un système de retraite sous-financé, les chercheurs ont été en mesure d’évaluer l’effet d’une telle exposition sur les attitudes liées à l’immigration. En outre, en sollicitant certaines des opinions des participants sur l’immigration jusqu’à 12 jours après l’étude d’évaluation des textes, ils ont pu examiner la persistance des effets du traitement au-delà de leur impact immédiat.

Les résultats révèlent un effet important et significatif de l’exposition aux traitements sur le soutien des citoyens à une politique d’immigration plus ouverte. L’ampleur des effets diffère selon les traitements, mais elle est systématiquement positive et souvent substantiellement importante. Par exemple, l’exposition à des informations sur le rôle potentiel des immigrants dans la résolution de la crise des retraites au Japon est associée à une augmentation de 21 points de pourcentage du soutien à l’idée d’autoriser davantage d’immigrants dans le pays. L’exposition à des informations sur l’impact de l’immigration sur la gestion de la diminution de la population du pays ou de la pénurie de personnel soignant pour les personnes âgées produit des changements un peu plus faibles (15 et 19 points de pourcentage, respectivement), mais toujours très significatifs. Compte tenu du taux de soutien de base de 29% au sein de la population générale, ces changements représentent une augmentation de 43 à 72%, des effets sans aucun doute considérables.

Les chercheurs ont aussi remarqué que le changement d’opinion ne persiste pas totalement avec le temps mais qu’il reste globalement positif et significatif, ce qui permet d’envisager que des changements durables sont effectivement survenus.

Comment expliquer le changement d’opinion que nous observons ? Plus précisément, une question ouverte est de savoir si les traitements entraînent un changement d’opinion en raison de l’amorçage de certaines questions – rendant certaines informations préexistantes plus accessibles – ou si l’effet est plutôt dû à l’exposition des personnes à de nouvelles informations. Leur expérience fournit quelques éléments suggestifs sur cette question, en utilisant des approximations du niveau de familiarité préalable des répondants avec l’information intégrée dans le traitement. Sur deux ensembles de comparaison différents, les résultats suggèrent que le dernier mécanisme, à savoir l’exposition à de nouvelles informations, est probablement le plus important des deux. Si c’est effectivement le cas, cela implique que des interventions similaires sont susceptibles d’avoir un impact plus fort dans des environnements à faible niveau d’information.

Une autre étude, cette fois aux États-Unis principalement mais aussi dans d’autres pays comme la France, les Pays-Bas ou encore la Pologne17, montre par exemple que dire à des personnes la réelle part d’immigrants sur leur territoire tend à nuancer leur vision et à la rendre moins radicale sur cette question, bien qu’ils restent inquiets. Un des points importants relevés par l’étude est celui de la transparence des chiffres et donc de leur communication. L’action publique a tout intérêt (si son but est de réellement informer et lutter contre le racisme et la xénophobie) à communiquer les statistiques relatives à ces questions afin que les gens aient des vraies données pour alimenter leur réflexion.

Des recherches montrent qu’effectivement les citoyens américains ont tendance à considérer qu’il y a plus de personnes issues de l’immigration qu’il n’y en a réellement. Pour autant, l’étude pointe le doigt sur quelque chose de primordial pour comprendre ce phénomène. Cette mauvaise perception du nombre d’immigrés est probablement une conséquences de biais cognitifs, et non pas une cause. Ainsi les gens ne sont pas contre l’immigration parce qu’ils pense qu’il « y en a trop », mais plutôt : ils pensent qu’il « y en a trop » parce qu’il y a déjà un biais cognitif présent chez eux qui les pousse à penser comme cela (le racisme, la xénophobie). Ce qui explique que, bien qu’ils ne puissent nier les chiffres, les personnes interrogées restent inquiètes quant à la question de l’immigration, puisqu’au final ce n’est pas le nombre d’étrangers sur leur territoire qui les inquiètent vraiment, mais plutôt simplement le fait qu’il y ait des étrangers18.

Les références utilisées dans cet exemple de l’immigration viennent aussi du livre d’Hugo Mercier. J’ai modifié les références puisque dans son ouvrage, certaines n’étaient pas encore publiées (je ne sais d’ailleurs pas trop quoi penser du fait d’utiliser des références pas encore publiées, cela me paraît assez risqué quant à la démarche scientifique). De plus, il est important ici de noter que les propos qui ont ouvert mon article mériteraient d’être nuancés et plus détaillés, puisqu’ici les gens ne changent pas vraiment d’avis sur la question de l’immigration. Ils sont prêts à reconnaître « qu’effectivement il n’y a pas autant de migrants que cela, mais tout de même, il y en a ! » Ainsi cela me paraît plutôt être un argument en moins dans leur besace, mais ils en ont d’autres. On imagine sans difficulté un Zemmour nous répondre que « peu importe combien ils sont, un c’est déjà trop, et regardez combien sont étrangers dans nos prisons ! »

On peut sûrement argumenter en disant que c’est déjà changer d’avis que de reconnaître la faiblesse d’un de nos arguments préférés, mais le vrai avis, celui qui consiste à penser que l’immigration n’a rien de bon à nous apporter, lui reste inchangé chez ces personnes (a priori, fautes de preuves contraires).

Ainsi, si on fait le parallèle avec la drogue, un avis serait que « la drogue c’est mal ». Présenter les chiffres de la mortalité et des maladies associées pour montrer que des drogues sont bien moins nocives que l’alcool ou le tabac permettrait peut-être de faire reconnaître à des personnes qu’effectivement, c’est pas si dangereux qu’on le dit, mais cela ne changerait pas nécessairement que « la drogue, c’est quand même mal ».

Le bayésianisme, utile pour changer de position ?

Hugo Mercier nous partage plusieurs références faisant mention du bayésianisme. Pour ceux qui ne connaitraient pas encore ce concept, des vidéos sont disponibles sur YouTube et plutôt bien faites afin de comprendre ce que c’est et quelle utilité cela peut avoir en général pour réajuster ses divers points de vue sur le monde. Christophe Michel et Lê Nguyên Hoang, entre autres, ont fait des vidéos claires sur le sujet.

Du coup, en résumé, qu’est-ce que la pensée bayésienne ? On trouve une explication sur Wikipédia :

L’inférence bayésienne est une méthode d’inférence statistique par laquelle on calcule les probabilités de diverses causes hypothétiques à partir de l’observation d’événements connus. Elle s’appuie principalement sur le théorème de Bayes.

Le raisonnement bayésien construit, à partir d’observations, une probabilité de la cause d’un type d’événements. On attribue à toute proposition de cause une valeur de sa probabilité, prise dans l’intervalle ouvert allant de 0 (contradiction, faux à coup sûr) à 1 (tautologie, vraie à coup sûr). Quand un événement possède plus de deux causes possibles, on considère une distribution de probabilité pour ces causes. Cette distribution est révisée à chaque nouvelle observation et s’affine de plus en plus. Ainsi, un diagnostic médical indique-t-il qu’une maladie plus qu’une autre est probablement à l’origine des symptômes d’un patient, et des examens renforcent ou infirment cette hypothèse.

Tout l’intérêt de cette méthode est de réévaluer nos opinions en fonction des nouvelles informations qui arrivent jusqu’à nous. Dans l’idée, c’est parfait. Quiconque un tant soit peu honnête intellectuellement se dit qu’il changera d’avis si c’est nécessaire, mais qui le fait vraiment ? C’est là qu’on se confronte aux limites des vidéastes sur YouTube, et qu’on a besoin de recherche scientifique sur la question afin de juger de l’efficacité réelle de tout ça. Malheureusement un trop grand nombre d’études citées par Hugo Mercier sont inaccessibles même via Sci Hub (et toujours ce problème de référence menant à un papier non publié).

Les papiers en question19 sembleraient indiquer qu’une approche bayésienne permet d’estimer la valeur d’arguments fallacieux comme la pente glissante ou encore le raisonnement circulaire. Les papiers montrent en effet qu’en fonction des sujets abordés les sophismes n’en sont pas forcément et peuvent même être, dans certains contextes, ce qu’on a de mieux pour soutenir une thèse (ce qui évidemment en dit long sur la thèse en question). De plus, la question des biais cognitifs pouvant interférer dans les décisions de changer ou non d’avis, est mentionnée dans les références partagées par Hugo Mercier20.

Mais du coup, est-ce qu’on peut vraiment changer d’avis ?

Les résultats d’une étude de 2018 sur Reddit21 suggèrent que même si les commentateurs de r/changemyview participent à un forum consacré à la remise en question de ses propres opinions, les membres de cette communauté ne sont pas particulièrement susceptibles de changer d’avis. De cette façon, les utilisateurs sont peut-être plus représentatifs de la façon dont les gens dans le vrai monde changent d’avis que ce à quoi on pourrait s’attendre au départ.

Il peut sembler que les résultats constituent une preuve de l’opinion pessimiste selon laquelle les gens ne peuvent pas se mettre d’accord sur les faits, s’il y en a, qui sont même pertinents dans les débats sur, par exemple, la politique, la moralité ou le genre. Les chercheurs ont constaté que, même si beaucoup plus de preuves sont citées dans les discussions sociales et morales, le changement d’attitude n’est pas plus fréquent dans ces discussions que dans les discussions avec une autre thématique.

Cependant, leurs données fournissent quelques raisons d’être optimiste : ils ont observé que la citation de sources et la référence à des données étaient positivement liées au changement d’attitude. Lorsqu’un fil de discussion contenait, par exemple, davantage de citations, de liens vers des sources externes ou de langage statistique, il prédisait positivement un changement d’attitude. De plus, ils ont constaté que cet effet ne dépendait pas de la nature sociomorale de la discussion. Ce résultat indique que lorsque les gens sont motivés pour s’intéresser à des informations pertinentes pour leurs croyances, citer des sources, fournir des données, etc, peut être une tactique efficace pour changer les opinions des gens.

Une étude citée plus de quatre mille fois va dans ce sens22 : les croyances et les opinions sont perçues comme des trésors à garder et à protéger. Seules les personnes, avec des avis peu élaborés et des attitudes moins affirmées sur le plan des idées, semblent moins biaisées politiquement. Cela rejoint les travaux de Mehdi Moussaid où il est clair que lorsqu’un politicien ou un lobby va chercher à gagner des consommateurs ou des électeurs, ce n’est pas les convaincus qui sont visés, mais les indécis.

Ce constat peut inciter à conclure que l’objectivité et la tolérance reposent davantage sur l’ignorance et l’apathie que sur les compétences d’élite de citoyens idéaux. Peut-être avons-nous cherché la citoyenneté rationnelle dans tous les mauvais endroits, et c’est la grande masse qui sauve la démocratie !

Taber, C. S., & Lodge, M. (2006). “Motivated skepticism in the evaluation of political beliefs.” American Journal of Political Science, 50(3), 755–769.

Conclusion au regard des données partagées dans le livre d’Hugo Mercier.

Que pouvons nous dire de son affirmation de départ ? Lorsque l’on défend une thèse, les fondations doivent être solides. On ne bâtit rien sur du vent. Je ne pense pas que les gens ne sont pas capables de changer d’avis, au contraire, mais finalement il semblerait surtout qu’ils changent d’avis sur des choses peu importantes qui ne remettent pas trop en question leurs croyances fondamentales et que cela dépend grandement des thématiques (santé, immigration, système social, religion, morale…), et pire, l’avis qui change peut simplement changer de sorte à renforcer une croyance bien ancrée (celle qu’on aimerait changer). Ainsi toutes les références partagées par ce chercheur en sciences cognitives semblent peu pertinentes si l’on veut être « sans appel » sur le fait que les gens changent d’avis en fonction des arguments solides. On voit plutôt dans toutes ces références une grande nuance quand ce n’est pas tout bonnement le contraire qui est affirmé.

Les propos tels qu’ils sont écrits dans le livre sont même trompeurs, puisqu’ils laissent penser que c’est ainsi que les gens se comportent naturellement en majorité : ils changent d’avis, sont rationnels et savent entendre les arguments leur donnant tort. Or il semble que ce soit plutôt le contraire, en moyenne, qui soit vrai (ou alors on décide de mettre sur le même plan les avis relatifs à la couleur des volets que les avis quant à la politique d’immigration ?).

Certains papiers mentionnent d’ailleurs certains des problèmes majeurs venant freiner le changement d’avis : les biais cognitifs et l’identité des personnes qui dépend des croyances qu’ils ont. Et cela paraît assez intuitif finalement, et bien moins extraordinaire que le contraire puisque c’est ce qu’on observe partout dans tous les sujets de discussion et de tensions politiques. Un livre intitulé « pas né de la dernière pluie« , qui aborde les sujets d’esprit critique, de rationalité, d’information publique, de croyances, de crédulité, se doit d’être totalement transparent sur les données qu’il cherche à transmettre. Et à mon avis toutes ces références derrière ces deux notes de bas de page semblent plutôt essayer de masquer la faiblesse de l’affirmation par la quantité, ce qui je trouve réduit considérablement la qualité du livre. L’auteur aurait du mieux détailler toutes ces références pour leur faire honneur et retransmettre de manière plus claires et honnêtes (le mot est lâché) afin de permettre au lecteur de décider de la manière la plus éclairée possible de ce qui est crédible ou non.

Je n’ai évidemment pas exploré chaque note à 100%, mais j’y ai passé suffisamment de temps pour voir que les avis sur cette question étaient loin d’être aussi tranchés que celui de l’auteur. Une simple lecture des conclusions et des biais méthodologiques permet de voir dans la plupart des références que les gens ne changent pas d’avis aussi facilement que l’auteur le laisse entendre. Dans l’absolu, c’est un message plutôt positif et si les gens y croient, cela peut enclencher des cercles vertueux. Mais je ne crois pas qu’il y ait de bonnes raisons de mentir et de manipuler en se servant de données scientifiques, puisque cela finira à terme par décrédibiliser la science en général et on retournera à la case départ où plus personne n’a confiance en rien. Lorsqu’on manipule des données scientifiques, il est important d’être le plus transparent possible et d’annoncer ses propres biais (ce que je m’efforce personnellement à faire au travers de la partie Esprit Ethique de ce blog).

Je ne suis pas un expert, mais je connais maintenant pas mal de choses en sciences cognitives, en psychologie, en biologie, en esprit critique… Et pourtant j’ai bien failli simplement lire ces passages et dire « chouette, bon bah j’avais tort » et continuer ma lecture. Combien vont lire ceci sans se poser de question ? Mais au final en allant voir les références je me suis mis à douter de plus en plus pour finalement ne plus réussir à me décrocher l’idée que nous avons là une erreur importante et un manque de rigueur scientifique. Même si un livre n’est pas soumis à comité de lecture par les pairs, le minimum pour un tel sujet devrait être de faire comme si c’était le cas et adopter une démarche la plus transparente possible.

L’importance des initiatives citoyennes et associatives face au désintérêt et à l’inertie de l’Etat.

Au final, que les gens puissent ou non réellement changer d’avis et appliquer concrètement les nouvelles idées, il faut tout d’abord des sources d’information fiables, afin d’avoir une base solide de laquelle on pourra développer des idées et des outils en tous genres. Que ce soit pour améliorer la démocratie, comprendre l’addiction ou encore trouver des solutions efficientes quant à la problématique climatique, il nous faut des personnes prêtes à créer l’information que l’on pourra utiliser pour trouver des solutions, comme les chercheurs dans les différents domaines de recherche scientifique.

En ce moment, il est difficile d’avoir l’impression que l’Etat remplit son rôle dans beaucoup de domaines, notamment ceux évoqués ci-dessus, mais d’un autre côté nous avons tout de même des associations de personnes dévouées et motivées pour prendre des initiatives.

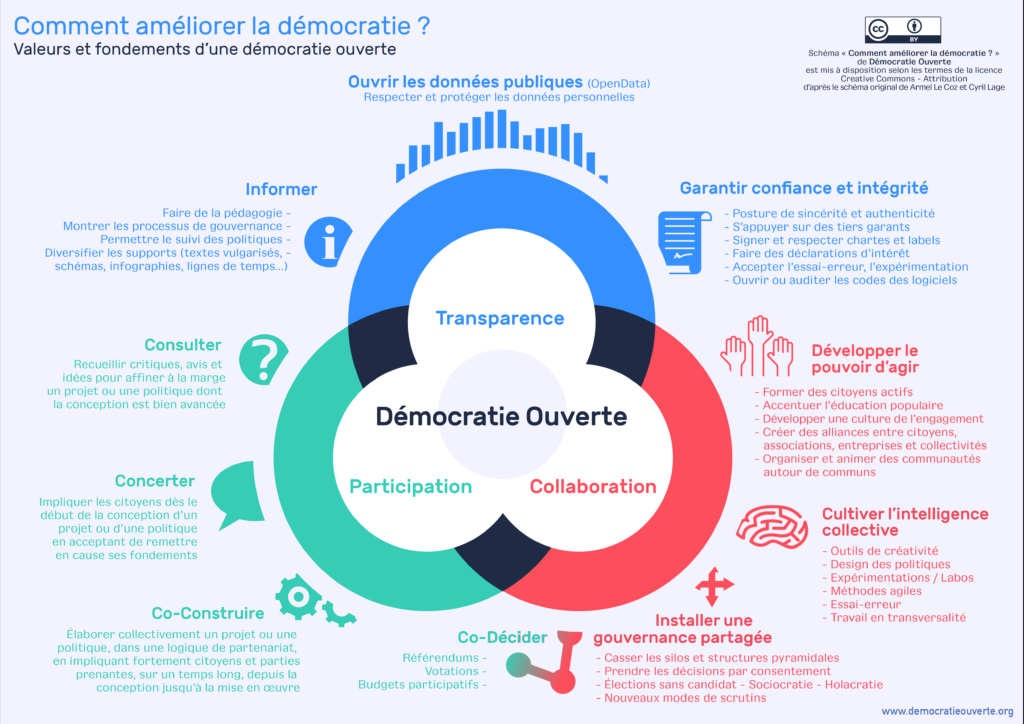

Comment améliorer la démocratie ?

Démocratie Ouverte est une association visant à modifier notre système politique afin de favoriser, justement, la démocratie. Elle est par exemple à l’initiative de la Convention Citoyenne pour le Climat.

Comment aider les addicts ?

La question des addictions en général mais surtout des substances psychoactives est très sensible en France. L’image des consommateurs est très négative et un lourd stigma leur est imposé au quotidien, surtout ceux qui consomment des substances illicites. Pour autant, un grand nombre d’informations pointe dans la direction qu’un grand nombre de drogues interdites sont moins nocives que celles autorisées. Il y a donc un positionnement de la société en contradiction avec la littérature scientifique sur le sujet (comme pour l’écologie, en soit). Des associations comme Fédération Addictions ou AIDES militent activement pour transmettre les informations sur le sujet, autant auprès du public que des professionnels de santé pas toujours au fait de ces informations.

Comment adopter des comportements écologique ?

J’ose croire qu’il y a de moins en moins de climato-sceptiques, néanmoins les preuves concrètes de changement de paradigmes se font rares. Il est donc toujours nécessaire de parler de ce sujet et de propager les informations relatives au changement climatique, à ses causes, et aux possibles solutions pour amortir les dégâts. De nombreuses personnes font un travail remarquable afin de permettre à chacun d’avoir accès aux connaissances et de s’en saisir.

Pour conclure, un prochain article sur les mécanismes psychologiques, sociologiques et neurobiologiques du changement d’avis permettra de mieux comprendre ce qui se passe lors du « déclic » qui fait se dire aux gens qu’ils avaient tort, ou tout du moins qui leur est nécessaire de changer d’avis.

* Ce passage est appuyé par les notes 5 et 17 de son chapitre 4, regroupant 26 références parmi lesquelles des articles non publiés et/ou difficilement accessibles, d’où mon envie de creuser tout ça. Pour rappel, un des piliers de l’esprit critique est le suivant : une affirmation extraordinaire nécessite des preuves plus qu’ordinaires.

[1] : Aird, M. J., Ecker, U. K., Swire, B., Berinsky, A. J., & Lewandowsky, S. (2018). “Does truth matter to voters? The effects of correcting political misinformation in an Australian sample.” Royal Society Open Science, 5(12), 180593.

[2] : Nyhan B, Reifler J. 2015 The effect of fact-checking on elites: a field experiment on US state legislators. Am. J. Polit. Sci. 59, 628 –640. (doi:10.1111/ajps.12162)

[3] : Berinsky AJ. 2017 Rumors and health care reform: experiments in political misinformation. Br. J. Polit. Sci. 47, 241–262. (doi:10.1017/S0007123415000186) ;

Swire B, Berinsky AJ, Lewandowsky S, Ecker UKH. 2017 Processing political misinformation: comprehending the Trump phenomenon. R. Soc. open sci. 4, 160802. (doi:10.1098/rsos.160802) ;

Swire B, Ecker UKH, Lewandowsky S. 2017 The role of familiarity in correcting inaccurate information. J. Exp. Psychol. Learn. Mem. Cogn. 43, 1948 –1961. (doi:10.1037/xlm0000422) ;

Nyhan B, Reifler J. 2015 Estimating fact-checking’s effects: evidence from a long term experiment during campaign 2014. Washington, DC: American Press Institute.

[4] : Chan, M. S., Jones, C. R., Hall Jamieson, K., & Albarracin, D. (2017). Debunking: A meta-analysis of the psychological efficacy of messages countering misinformation. Psychological Science, 28(11), 1531–1546.

[5] : Lewandowsky, S., Cook, J., Oberauer, K., Brophy, S., Lloyd, E. A., & Marriott, M. (2015). Recurrent fury: Conspiratorial discourse in the blogosphere triggered by research on the role of conspiracist ideation in climate denial. Journal of Social and Political Psychology, 3, 161–197. doi:10.5964/jspp.v3i1.443

[6] : Sperber, D. (2009). Culturally transmitted misbeliefs. Behavioral & Brain Sciences, 32, 534–535. doi:10.1017/S0140525X09991348

[7] : Hart, W., Albarrací n, D., Eagly, A. H., Brechan, I., Lindberg, M. J., & Merrill, L. (2009). Feeling validated versus being correct: A meta-analysis of selective exposure to information. Psychological Bulletin, 135, 555–588. doi:10.1037/a0015701

[8] : Thorson, E. A. (2013). Belief echoes: The persistent effects of corrected misinformation (Doctoral dissertation, University of Pennsylvania). Retrieved from http://repository.upenn.edu/dissertations/AAI3564225

[9] : Ecker, U. K., O’Reilly, Z., Reid, J. S., & Chang, E. P. (2019). The effectiveness of short-format refutational fact-checks. British Journal of Psychology. https://doi.org/10.1111/bjop.12383.

[10] : Guillory, J. J., & Geraci, L. (2013). Correcting erroneous inferences in memory: The role of source credibility. Journal of Applied Research in Memory and Cognition, 2, 201–209. https://doi.org/10.1016/j.jarmac.2013.10.001;

Margolin, D. B., Hannak, A., & Weber, I. (2018). Political fact-checking on twitter: When do corrections have an effect? Political Communication, 35, 196–219. https://doi.org/10.1080/10584609.2017.1334018 ;

Swire, B., Berinsky, A. J., Lewandowsky, S., & Ecker, U. K. H. (2017). Processing political misinformation: Comprehending the Trump phenomenon. Royal Society Open Science, 4,160802. https://doi.org/10.1098/rsos.160802

[11] : Guess, A., & Coppock, A. (2018). “Does counter-attitudinal information cause backlash? Results from three large survey experiments.” British Journal of Political Science. https://doi.org/10.1017/S0007123418000327.

[12] : van der Linden, S., Maibach, E., & Leiserowitz, A. (2019, May). “Exposure to scientific consensus does not cause psychological reactance.” Environmental Communication, DOI: https://doi.org/10.1080/17524032.2019.1617763

[13] : Walter, N., & Murphy, S. T. (2018). “How to unring the bell: A meta-analytic approach to correction of misinformation.” Communication Monographs, 85(3), 1–19.

[14] : Nyhan, B., Reifler, J., & Ubel, P. A. (2013). The hazards of correcting myths about health care reform. Medical Care, 51, 127–132. doi:10.1097/MLR.0b013e318279486b

[15] : Park, S. (2017). Inventing aliens: immigration control, “xenophobia” and racism in Japan. Race & Class, 58(3), 64–80. doi:10.1177/0306396816657719

[16] : Facchini, G., Margalit, Y., & Nakata, H. (2022). Countering public opposition to immigration: The impact of information campaigns. European Economic Review, 141, 103959.

[17] : Grigorieff, A., Roth, C., & Ubfal, D. (2020). Does Information Change Attitudes Toward Immigrants? Demography. doi:10.1007/s13524-020-00882-8

[18] : Hopkins, D. J., Sides, J., & Citrin, J. (2019). “The muted consequences of correct information about immigration.” Journal of Politics, 81(1), 315–320.

[19] : Hahn, U., & Oaksford, M. (2007). The rationality of informal argumentation: A Bayesian approach to reasoning fallacies. Psychological Review, 114(3), 704–732. doi:10.1037/0033-295x.114.3.704 ;

Guess, A., & Coppock, A. (2015). Back to Bayes: Confronting the evidence on attitude polarization. Unpublished manuscript. Retrieved from https://pdfs.semanticscholar.org/23fc/c2e9e5706a766148e71624dc0f78e3cbf8ef.pdf ;

Hill, S. J. (2017). “Learning together slowly: Bayesian learning about political facts.” Journal of Politics, 79(4), 1403–1418. ;

Tappin, B. M., & Gadsby, S. (2019). “Biased belief in the Bayesian brain: A deeper look at the evidence.” Consciousness and Cognition, 68, 107–114.

[20] : Mercier, H. (2016b). “Confirmation (or myside) bias.” In R. Pohl (Ed.), Cognitive Illusions (2nd ed., pp. 99–114). London: Psychology Press. ;

Trouche, E., Shao, J., & Mercier, H. (2019). “How is argument evaluation biased?” Argumentation, 33(1), 23–43. ;

Edwards, K., & Smith, E. E. (1996). “A disconfirmation bias in the evaluation of arguments.” Journal of Personality and Social Psychology, 71(1), 5–24.

[21] : Priniski, J., & Horne, Z. (2018). “Attitude change on Reddit’s change my view.” Proceedings of the Cognitive Science Society Conference.

[22] : Taber, C. S., & Lodge, M. (2006). “Motivated skepticism in the evaluation of political beliefs.” American Journal of Political Science, 50(3), 755–769.